Anton

Reiter

30.

Jahrestagung der Gesellschaft für Informatik an der TU Berlin.

Unter dem Motto “Neue Horizonte im neuen Jahrhundert“ fand vom 19. bis

zum 22. September 2000 in den Räumen des Mathematikgebäudes an der TU Berlin

(Straße des 17. Juni gegenüber dem Ernst Reuter-Platz) die 30. Jahrestagung der

Gesellschaft für Informatik (GI) statt. Diese

auch international ausgerichtete Veranstaltung wurde von der

Gesellschaft für Informatik, der Technischen Universität Berlin, der Humboldt-

Universität und der Freien Universität Berlin gemeinsam organisiert.

im Bild (ã

Dr. Reiter) das Mathematikgebäude der TU Berlin, Tagungsort der 30.

GI-Jahrestagung, von außen

und im Innern (ã

Dr. Reiter)

Schwerpunkte der 30. GI-Jahrestagung

Zentral für die Tagung waren Fragen zur

Verbesserung und Orientierung von Ausbildung und Forschung. Dem Thema „Zukunft der Informatik-Ausbildung“ mit

Beiträgen zu Inhalt und Struktur des deutschen Ausbildungssystems, aber auch

zur technischen Weiterentwicklung durch den Einsatz neuer Medien, wurde

entsprechend hohe Aufmerksamkeit gewidmet. In den Vorträgen und

Podiumsdiskussionen wurden Themen wie

die Angleichung der universitären Ausbildungsgänge an die international

verbreiteten Bachelor- und

Master-Studiengänge, das Verhältnis zwischen Universitäten, Fachhochschulen

und Privatuniversitäten sowie neue Lehrformen und neue curriculare Strukturen

behandelt. Angesichts des anhaltenden Fachkräftemangels - Stichwort „Greencard“

- erhielt das Thema „Zukunft der Informatik-Ausbildung“ eine erhöhte Brisanz.

Als ein ganz neuer Forschungsschwerpunkt wurde die so genannte Bioinformatik vorgestellt.

Ein zweiter zentraler Teil der 30.

GI-Jahrestagung wurde von Vertretern der „Jungen

Informatik“ dargeboten, die ihre Ergebnisse vorstellten und damit aktuelle

Trends deutlich machten. So waren von der „Jungen Informatik“ 18 Beiträge

eingereicht worden, die allesamt vom Programmkomitee angenommen wurden. Diese

Beiträge behandelten Themen wie z. B: Computerarchitektur, Softwaretechnik, Algorithmik,

Computerlinguistik u.a.m. Die meisten

Referenten in diesem Block hatten ihr (zukunftsweisendes) Thema (bereits) im

Rahmen ihrer Dissertation bearbeitet.

Ein weiteres derzeit wichtiges

Forschungsthema in der Informatik stellt aus der Sicht der Praxis die Softwaretechnik dar. Zum Thema

„Softwaretechnik 2000“ waren weitaus mehr Papers eingereicht worden, als dann

angenommen wurden. Die insgesamt 7

Beiträge wurden auf die Kategorien „Prozess“ und „Objektorientierung“

aufgeteilt und repräsentierten damit die Hauptinteressen der (deutschen)

Softwaretechnologien. Ziel der Veranstalter war es, mit der Integration der

Fachtagung „Softwaretechnik“ in die GI-Jahrestagung ein breites Publikum über

neue Trends und Entwicklungen zu informieren. Gerade die „objektorientierte Entwicklung“ hat an

Bedeutung gewonnen, Entwurfsmuster und Frameworks stoßen sowohl in der Praxis

als auch in der Forschung auf reges Interesse.

Abgerundet wurde die Tagung durch Workshops und Tutorials zu aktuellen Themen wie beispielsweise „Electronic

Government“, „Sicherheit in Mediendaten“, „Unternehmen Hochschule“, „Grafiktag

2000“, „Lehrerbildung

Informatik-Konzepte und Erfahrungen“, Multimediales Lernen im Internet“ (der

Berichterstatter nahm an den beiden letzteren teil) u.a.m.

Zum Begriff Informatik

Eine allgemein anerkannte Definition

lautet: „Informatik ist eine

Ingenieurwissenschaft, die sich mit der systematischen und automatischen

Verarbeitung, Darstellung, Speicherung und Übertragung von Information aus

Sicht der Hardware, der Software, der Grundlagen, der Anwendungen und der

Auswirkungen befasst“. Zu den wichtigsten Hauptgebieten der Informatik zählen die Theoretische Informatik (z.B. Algorithmen und Datenstrukturen,

Komplexitätstheorie, formale Sprachen,...), die Praktische Informatik (z.B. Softwaretechnik, Systemarchitektur,

Programmiersprachen,...) die Technische

Informatik (z.B. Schaltungen, Rechnerarchitektur, vernetzte Systeme,...)

und die Angewandte Informatik (z.B.

Systemanalyse, CAD/CAM integrierte Systeme, Didaktik der Informatik,...).

Die besondere Befähigung von

Informatikerinnen und Informatikern liegt in der Analyse, Konzipierung und

Konfigurierung von Hard- und Softwaresystemen und deren Einbettung in

bestehende Umgebungen, in der Planung und Organisation, in der Anpassung von

System- und Anwendungssoftware, im Erschließen neuer Einsatzgebiete und auch in

der Schulung. Heutzutage kommt der Informatik in immer mehr Gebieten eine

unaufhörlich wachsende Bedeutung zu. Viele ihrer Anwendungen werden zu den

volkswirtschaftlich bedeutsamen Schlüssel- und Wachstumstechnologien gezählt.

Der Einsatz von Computern in Wissenschaft, Wirtschaft, Verwaltung und im

öffentlichen Leben trägt z.B. zur Gewinnung neuer Erkenntnisse, zur erhöhten Sicherheit von technischen

Anlagen und des Verkehrs sowie auch zum sparsameren Verbrauch von Ressourcen

bei. Computer erweitern die Forschungs- und Arbeitsmöglichkeiten nicht nur in

den Natur- und

Ingenieurswissenschaften, sondern zunehmend auch in den Geistes- und

Sozialwissenschaften. Die Informatikberufe entwickeln sich besonders rasch,

existierende Berufsfelder sind noch lange nicht in allen Aspekten klar

umrissen, ständig entstehen neue IT-Berufe. Unabdingbar für ein

Informatikstudium sind Interesse an logischem Denken und hohe Konzentrationsfähigkeit

sowie die Fähigkeit zur Einarbeitung in komplexe Systeme, auch Interesse an

technischen Zusammenhängen sollte vorliegen.

Tutorium:

Multimediales Lernen im Internet

(Vortragende: Prof. Dr. Wolfgang

Effelsberg, Universität Mannheim und Dr. Stephan Fischer, GMD Darmstadt)

im Bild Prof. Dr. Wolfgang Effelsberg (ã

Dr. Reiter)

und Dr. Stephan Fischer (ã

Dr. Reiter)

Eines von mehreren Tutorien am ersten

Konferenztag (19.9.2000) unter dem Titel „Multimediales Lernen und Lehren im

Internet“, an dem der Berichterstatter teilnahm, wurde von zwei Vortragenden

abgehandelt. Während Prof. Dr. Effelsberg den aktuellen Stand von Multimedia

aus technischer Hinsicht erläuterte (erklärt wurde z.B. das Prinzip der

Datenkompression, moderne Übertragungstechniken für kontinuierliche

Datenströme, die Funktion von Teachware -Servern), befasste sich Dr. Fischer

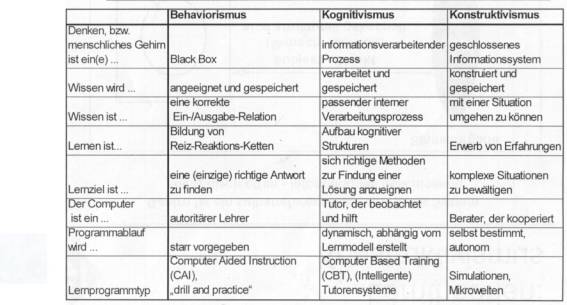

zunächst mit den Grundlagen für multimediales Lernen. Erklärt wurden die drei

gängigsten Lerntheorien: Behaviorismus, Kognitivismus und der moderne

Konstruktivismus. Schließlich ging Dr. Fischer auf das „Lernen mit Hypermedia“

ein und erläuterte die Funktionsweise von „adaptiven Lernsystemen“.

Gegenüberstellung der drei bekanntesten Lerntheorien (aus

dem Vortragsskriptum)

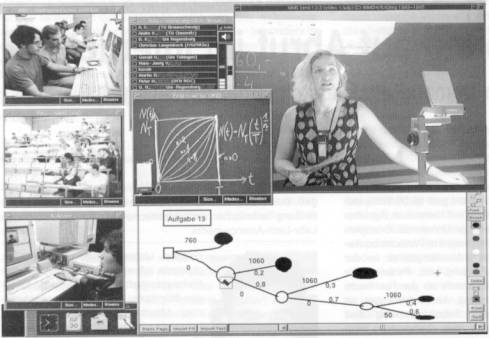

Im Anschluss daran referierte Dr.

Effelsberg über das seit 1996 an den

Universitäten Mannheim, Heidelberg, Karlsruhe und Freiburg laufende

Verbundprogramm unter dem Projekttitel „VIROR“, in dem es um „Teleteaching und

Telelearning“ auf universitärer Ebene geht. Der Schwerpunkt liegt dabei in

synchronen Lernszenarien, worunter eine zeitgleiche (Internet-) Übertragung

einer Lehrveranstaltung an verschiedenen Orte zu verstehen ist. Die Audio- und

Videoströme des Dozenten werden zugleich aufgezeichnet und als Bestandteil eines

Computer Based Trainings zeitunabhängig für asynchrone Lernszenarien zur

Verfügung gestellt. Gleichzeitig setzt man ein Whiteboard als elektronische

Tafel ein, um schriftliche Dokumente bei den Teilnehmern anzuzeigen. Viele

europäische Universitäten betreiben derzeit aktuelle Forschungsprojekte über

Technik, Anwendungen und Auswirkungen von Fernlehre.

Teleteaching wird durchgeführt in

synchronen und asynchronen Lernszenarien. Unter einem synchronen Szenario

versteht man dabei Lehre zur gleichen Zeit an verschiedenen Orten, während

asynchrone Lehre zeitunabhängiges Lernen an verschiedenen Orten bezeichnet.

Beide Szenarien haben vielfältige Vorteile: ein Dozent kann Studierende an

verschiedenen Orten gleichzeitig unterrichten. Dabei eingesparte Zeit, indem

gleicher Inhalt nicht mehrfach parallel unterrichtet werden muss, oder

eingesparte Zeit durch weniger Reisetätigkeit, kann der inhaltlichen

Aufarbeitung des Stoffes zugute kommen. Studierende nutzen bereitgestelltes

Lernmaterial für asynchrones Lernen gerne, um nach eigenem Geschmack und

eigener Geschwindigkeit lernen zu können. Das Hauptziel synchronen

Teleteachings ist aber, Ortsunabhängigkeit zwischen Dozenten und Studierenden

zu erreichen.

Der Onlinebetrieb im VIROR-Projekt

wurde auch wissenschaftlich ausgewertet. Ein

Ergebnis ist der Umstand, dass die Fernlernenden es bedeutend

schwerwiegender empfanden, wenn die Audioleitungen unterbrochen waren bzw. ein

schlechter Ton zu hören war, als wenn beispielsweise kurzfristige

Bildverzerrungen oder -ausfälle eintraten.

Exemplarisches

Bildschirmlayout während einer verteilten Vorlesung an der Universität Erlangen

(Quelle: PIK, 23. Jg. , S. 138)

Dr. Effelsberg beschrieb anschließend

die erforderlichen HW- und SW- Konfigurationen, u.a. die Funktionsweise des so

genannten Whiteboards und die verschieden Formen von Videoconferencing;

abschließend stellte Dr. Fischer das von ihm geführte Projekt „Multibook“

vor, das eine Online-Wissensbasis

darstellt mit allen Features interaktiver Online-Module.

Workshop: Lehrerbildung und Informatik – Konzept und Erfahrungen

Ansicht auf die freie

Universität Berlin (ã Dr. Reiter)

Am ersten Tag fand parallel und fernab

der technischen Universität am Ernst Reuter-Platz an der Freien Universität

Berlin ein sehr interessanter Workshop zum Thema „Lehrerbildung und Informatik

– Konzept und Erfahrungen“ statt, an dem der Berichterstatter nachmittags

teilnahm. Organisiert wurde dieser Workshop von

den bekannten Informatikprofessoren Dr.

Sigrid Schubert (Universität Dortmund)

und Dr. Andreas Schwill (Universität Potsdam). Ausgangspunkt für den Workshop

bildete die Diskussion um die Greencard für ausländische Fachkräfte im IT-

Bereich, die insgesamt den großen Nachholbedarf der informatischen Bildung auf

allen Ebenen der Ausbildung aufzeigen würde, wurde argumentiert. So existiert

in Deutschland (wenn auch in unterschiedlicher Weise) an den allgemein

bildenden und beruflichen Schulen seit mehr als 30 Jahren das Lehramt

Informatik, welches aber lange Zeit und zum Teil auch heute noch ohne

grundständiges Studium der Informatik zuerkannt wurde und wird. In den letzten

Jahren änderte sich dieses mit vermehrten Studiengängen zum Lehramt Informatik

für die Sekundarstufen 1 und 2.

Workshop-Teilnehmer

Prof.

Schubert und Schwill kritisierten unisono, dass auch heute noch die weit

überwiegende Zahl der Informatiklehrer durch Weiterbildungsmaßnahmen

ausgebildet werden, auch weiterhin existiert ein Mangel an gut ausgebildeten

Informatiklehrern (nicht nur in Deutschland). Gründe dafür sind nach Dr.

Schwill die viel zu geringe Zahl von Studienanfängern, die Abwanderung von

Absolventen in attraktivere Bereiche der Wirtschaft, zum Teil aber auch

ungeeignete Studienkonzepte.

Dr. Schubert ging davon aus, das - um

informatische Bildung in Schulen gestalten zu können, die Lehrer in die Lage

versetzt werden müssen, attraktive und zeitgemäße Lehrpläne, Unterrichtsreihen

und -entwürfe zu gestalten und entsprechend der dynamischen Entwicklung der

Informatik fortzuentwickeln. Ferner müssen diese die Fähigkeit erwerben,

forderte Schubert, das interdisziplinäre Potenzial Informatik in Zusammenarbeit

mit den anderen Schulfächern freizusetzen. Das kann mit

wissenschaftstheoretischen Erkenntnissen zur Charakteristik des Faches und

seinen Innen- bzw. Außenbeziehungen

(fundamentale Ideen) gefördert werden. Bisher fänden sich dazu Ansätze

in der Didaktik der Informatik. Dies genügt aber noch nicht, vielmehr müssen

zentrale curriculare Normen, Strukturbeziehungen der Wissenschaft und

methodische Vorgehensweisen den gesamten Lernstudiengang selbst durchsetzen.

Ziel dieses Workshops war es insgesamt,

den Erfahrungsaustausch zu allen Formen der lehrerbildenden Informatik zu

fördern. Der Schwerpunkt lag auf Konzepten zur grundständigen Ausbildung von

Lehrkräften in Informatik, daneben wurden auch Aspekte der Lehrerfort- und

-Weiterbildung behandelt. Die zum Workshop eingereichten 10 Beiträge wurden in

2 Schwerpunkte unterteilt:

1. Informatik für

alle Lehrämter

2. Lehramt

Informatik

Ausgewählte Beiträge sollen nach Begutachtung

in überarbeiteter Form in der elektronischen Zeitschrift „informatica didacta“,

Zeitschrift für fachdidaktische Grundlagen der Informatik“ erscheinen (http://didaktik.cs.uni-potsdam.de/informaticDidacta

publiziert werden.

Schwerpunkte der Haupttagung

Eröffnet wurde die Haupttagung am 20.

September durch den Staatssekretär im Bundesministerium für Bildung und

Forschung, Herrn Dr. Uwe Thomas. Er

unterstrich in seinem Vortrag die derzeitigen Trends in der Informations- und

Kommunikationsgesellschaft: Mobilfunk, new economy und Internet. Besonders das

Internet habe massive Veränderungen im Bildungswesen in allen Sparten des

Bildungswesens bewirkt. Thomas begrüsste besonders die Initiative „Schulen ans

Netz“ (bis 2001 sollen alle deutschen Schulen am Netz sein) und sprach sich für

eine gezielte Förderung der Entwicklung von Lernsoftware aus. Informatik der

Zukunft werde von der Mathematik, von der Mensch-Maschine-Schnittstelle, von biologischen

Systemen und vom Mediendesign bestimmt werden, meinte Staatssekretär Thomas.

Die über die Grenzen Deutschlands hinaus bekannte GMD (Gesellschaft für

Mathematik und Datenverarbeitung) wird in naher Zukunft ein so genanntes „Center of Excellence“ aufbauen, in das

rund eine halbe Milliarde DM für Forschung und Entwicklungszwecke auf der Ebene

Software-Engineering investiert werden soll. Durchaus wichtig ist dabei nach

Thomas die Verkettung einer langfristigen Grundlagenforschung mit der

Entwicklungsdynamik bei den Mikroprozessoren, um weit bessere Ergebnisse zu

erzielen.

im Bild

Staatssekretär Dr. Uwe Thomas (ã Dr. Reiter)

Den ersten Hauptvortrag hielt Prof. Dr.

Andreas Reuter (International

University in Germany, Bruchsal) zum Thema „Informatikausbildung der Zukunft“.

Informatik wird zukünftig ein integraler Bestandteil aller Disziplinen sein,

ohne IT Kenntnisse wird man nicht mehr auskommen. „IT als Disziplin, als Methode, allgegenwärtig und umfassend.

Informatik als Grundlagendisziplin, als Werkzeug des täglichen Lebens“. Das

ist das Szenario. In Zukunft wird es keine strikte Trennung mehr geben zwischen

Ausbildung und Berufstätigkeit, man wird sich mehr und mehr auch im Berufsleben

auf neue Entwicklungen anpassen müssen und ständig dazulernen. Eine ständige

Weiterbildung ist der einzige Ausweg, um die Dynamik in den Griff zu bekommen,

sagte Reuter. Es entstehen neue Berufe,

so genannte Bildungsbroker, die einfach Ausbildungspläne erarbeiten und

vorlegen werden. Es müsse noch viel mehr in die Informatikforschung investiert

werden, besonders auch in die Schnittstelle Mensch-Computer (Human Computer

Interface, HCI). Leider sei in

Deutschland, meinte Prof. Dr.

Reuter, Informatik Sache der Länder,

darum gebe es auch so unterschiedliche

Regelungen und keine wirkliche Einheitlichkeit in den Studienplänen. Es

müssen mehr Möglichkeiten zur informatischen Weiterbildung geschaffen werden,

die Lösung kann nicht sein, das man erfolgreiche Weiterbildungs- oder

Studiengänge ersetzt durch die von Außen herangetragene Ausbildung zum Bachelor

oder Master.

Prof. Dr. Ernst

Reuter, der einen sehr pointierten Vortrag hielt (ã

Dr. Reiter)

Der Bereich „Telelearning –Teleteaching“ wurde mehrfach und von verschiedenen

Blickpunkten am ersten Tag abgehandelt. Unter anderem hielt auch von Prof. Dr.

Thomas Ottmann (Universität

Freiburg) einen Vortrag über „Möglichkeiten um Grenzen der Virtualisierung des

Informatikstudiums“: “Die Hochschullehrer

im Fach Informatik an den Präsenzuniversitäten haben in den letzten Jahren damit

begonnen, ihr gesamtes Lehr- und Lernmaterial , also Skripten,

Foliensammlungen, Übungsaufgaben und Lösungen, bis hin zu elektronischen

Versionen von Lehrbüchern, systtematisch im Web verfügbar zu machen“ (S. 6

im Tagungsband). Prof. Dr. Wolfgang Effelsberg

(nach dem Workshop am Vortag) behandelte das verwandte Thema „Lehren und

lernen im Internet -Herausforderungen an die Informatik“ Prof. Dr. Bernd Krämer (Fernuniversität Hagen) referierte zum Thema „Interaktive

Lernsysteme im Fernstudium: Betrachtung eines Programmierkurses im Zeitraffer“:

„Das Internet, kostengünstige

Mulltimediatechnik und breitbandige Kommunikationsnetze eröffnen nun völlig

neue Möglichkeiten, das zeit- und ortsungebundene Lernen zu gestalten,...“

(S.12 im Tagungsband) Am Nachmittag

wurde auch öfters die Frage aufgeworfen „Ist der Bachelor unausweichlich?“, die

mit unterschiedlichen Argumenten, mit Pro- und Kontra-Meinungen, beantwortet

wurde: „Bachelor sofort oder später, Bachelor allein oder mit Master oder nur

Master, Bachelor als eigener Studiengang oder als Variante des

Diplomstudiengangs usw. Um

Kompatibilität mit ausländischen Zwischen- und Endzeugnissen

herzustellen, wäre es ausreichend, wurde argumentiert, einige internationale Abkommen

zu schließen und an wenigen Informatik-Standorten gesonderte

Bachelor-Studiengänge einzurichten. Viele sind der Meinung, dass die

Qualifikation der Absolventen nicht gesteigert werden kann, wenn man dadurch

die Studiendauer verkürzt.

im Auditorium,

darunter auch der OCG-Vizepräsident Univ.-Prof. Dr Futschek (Bildmitte) (ã

Dr. Reiter)

Kritik wurde auch an der „Effizienz von Multimedia“ geübt, steht

doch der Aspekt der Lernwirksamkeit im Vordergrund. Erwartet wird die

Qualitätssteigerung und damit auch verbesserte Möglichkeiten der Selbstaneignung

des Lehrmaterials. Prof. Dr. Reinhard Keil-Slawik (Heinz-Nixdorf-Institut,

Universität Paderborn): „Zwar ist es

richtig, das durch verbesserte sinnliche Qualitäten in der Aufbereitung des

Lernmaterials Aneignungs- und Behaltenspotenziale besser unterstützt werden

können, doch ist dies keine generelle Qualitität von Multimedia, die sich zum

Beispiel durch die Verknüpfung von Ton, Text und Bewegbild gewissermaßen von

alleine einstellt. Vielmehr kommt es meist drauf an, diese Materialien geeignet

in die sozialen Lernprozesse der Lernenden und Lehrenden einzubetten. Die

besondere Betonung der Lernwirksamkeit zielt jedoch auf die individuelle

Aneignung vorgefertigter Materialien“ (Keil-Slawik 2000, S. 34 im

Tagungsband).

Am zweiten Tag (20.9.2000) stand die

„Bioinformatik“ neben der „Jungen Informatik „im Mittelpunkt. Bioinformatik

gilt nach Prof. Dr. Hans-Jürgen Thiessen

(Medizinische Fakultät, Universität Rostock) zurzeit als die

Schlüsseltechnologie in Life-Sience-Bereich. Sie beschäftigt sich hauptsächlich

mit der Analyse und Klassifizierung von DNA -, RNA und Proteinstrukturen. Dabei

übernimmt sie das Informationsmanagement, simuliert einzelne Prozessabläufe,

beschreibt Molekülstrukturen, Molekülinteraktionen, metabolische und

regulatorische Netzwerke, Zellorganisationen, ganze Zellen und ihre

Interaktionen bis hin zu ganzen Organismen. Makroskopische und mikroskopische

Biowissenschaften rücken zusammen und werden somit einer ganzheitlichen

Betrachtung zugeführt. Beider Suche nach neuen Medikamenten werden im sog.

Hochdurchsatzverfahren (High-througoutput-Screening, HTS) unter anderem

biologische Prozesse parametrisiert und quantrifiziert. Um dieses zukünftig

noch effizienter unter Einbindung einer

genomorientierten Bioinformatik in den Forschungs und

Entwicklungsabteilungen der Wirtschaft und den akademischen Instituten zu

realisieren, sind hohe Anforderungen auch an die Lehrinhalte der zukünftigen

Studiengänge für Bioinformatik und der Qualifikation ihrer Lehrstuhlinhaber zu

stellen. Bioinformatik wird sich langfristig von einer unterstützenden

Wissenschaftsdisziplin zu einer eigenständigen Disziplin fortentwickeln, die

vollständige Simulation einer lebenden Zelle bzw. Organismus mit all seinen

Funktionen in Raum und Zeit wird eine große intellektuelle Herausforderung für

die nächsten Generationen sein. Zurzeit ist es allerdings noch nicht einmal

möglich, Proteinfaltungsstrukturen eindeutig vorherzusagen, geschweige denn die

Funktion eines Proteins oder dessen Interaktion mit anderen Makromolekülen zu

prognostizieren. Obgleich experimentell jede Aminosäurekombination (Sequenz) im

Labor synthetisiert werden könnte, verfügen wir bisher nicht über den „Newton

der modernen Biologie“, der uns das entsprechende Regelwerk zum Design dieser

De-Novo-Proteine (Enzyme) überlässt, schränkte Prof. Dr. Thiessen ein (siehe S.

55ff. im Tagungsband) .

Die fachbezogenen Spezialthemen der am

Nachmittag des zweiten Tages teilweise in parallelen Veranstaltungen von

Repräsentanten der Jungen Informatik

beinhalteten Aspekte wie

„Methoden der künstlichen Intelligenz“ (symbolische Repräsentation),

Musterdatenbanken, Realzeitsuche, auch konkrete Ansätze wie etwa Anforderungen

an die Software-Entwicklungswerkzeuge, Lernen von Algorithmen mit interaktiven

Visualisierungen, mathematische Modelle u.v.a.m.

Architektur-Skizze

(aus Tagungsband S. 97)

Schlussbetrachtung

Während der vier Veranstaltungstage

zeigte sich ein erkennbarer Aufwärtstrend der deutschen Hochschulinformatik,

die auch weiterhin in einer engen Zusammenarbeit mit der Industrie ihre

Entwicklungs- und Forschungsvorhaben finanzieren will. Inmitten der Diskussion

um eine Änderung einzelner Informatikstudiengänge durch die Einführung von

zusätzlichen Bachelor- und Masterstudien, vor allem auch durch die einerseits betriebene,

andererseits mit Argwohn verfolgte Ausweitung der privaten (z.T. ausländischen)

Universitäten im ganzen deutschen Bundesgebiet kam insgesamt die

Schulinformatik viel zu kurz. Der am ersten Tag an der Freien Universität

stattgefundene Workshop zeigte augenscheinlich die große Diskrepanz in den

deutschen Bundesländern auf, in denen es durchwegs völlig unterschiedliche

Informatikcuriccula an den allgemein bildenden und beruflichen Schulen gibt. Im

Vergleich zu Österreich, wo (für viele)

erfreulicherweise ab dem WS 2000/01 an drei Standorten mit dem

Informatiklehramststudium (Informatikmanager) begonnen wird, gibt es in

Deutschland (noch immer) kein eigenes Informatiklehramtsstudium. Der

Berichterstatter bekam auch den Eindruck, das sich die führenden Köpfe der

deutschen universitären Informatikszene nicht mit außeruniversitären Problemen

beschäftigen, das also eine Art Zwei- Weltentheorie besteht: Das, was

Informatik an den Schulen der

Sekundarstufe 1 und 2 sein könnte/sollte ist die eine Welt, die andere Welt

ruht im tertiären Sektor und koppelt sich ab. Die beeindruckenden Highlights

allerdings für den Berichterstatter waren die Themen der aufstrebenden

Bioinformatik und letztendlich auch das hohe Potenzial des wissenschaftlichen

Informatiknachwuchses, deren Vertreter – wie betont wurde, fast alle samt in

die Wirtschaft bzw. an amerikanischen Universität „abtrifften“ werden. Im

Vergleich zu österreichischen Hochschulstandorten ist Teleteaching und

Telelearning vor allem an den zitierten VIROR-Universitäten erfreulich weit

gediehen.

Die 30. Jahrestagung für Gesellschaft für Informatik ermöglichte dem Berichterstatter auch die Kontaktaufnahme mit möglichen Referenten (Effelsberg, Schwill, Schubert,...) für den von ihm bereits fixierten Themenkreis „Die Zukunft der Schulinformatik“ im September 2001 im Rahmen der Informationstagung Mikroelektronik, die vom BMBWK gemeinsam mit der TU Wien und Seibersdorf getragen werden wird. Ein fruchtbarer Meinungsaustausch hat also vorweg in Berlin stattgefunden.

Literaturverweise:

Kurt Melhorn/Gregor Snelting (Hrsg.):

Informatik 2000. Neue Horizonte im neuen Jahrhundert, Tagungsband zur 30.

GI-Jahrestagung 2000 (19. –22. 9. 2000), Berlin-Heidelberg-New York (Springer)

2000

Fachzeitschrift für den Einsatz von

Informationssystemen: „Praxis der

Informationsverarbeitung und Kommunikation“, 23. Jahrgang, 3/2000, K.G. Saur

Verlag

Unterlage zum Workshop „ Lehrerbildung

Informatik – Konzepte und Erfahrungen“, hrsg. von Prof. Dr. Sigrid Schubert und

Prof. Dr. Andreas Schwill